東京大学大学院 情報理工学系研究科 創造情報学専攻 博士課程3年の韓 昌熙です。出身は読んで字のごとく韓国ですが、高校に進まずに大検後、16歳で東大に合格し来日しました。

現在東大と国立情報学研究所・医療ビッグデータ研究センターと国立国際医療研究センター病院・放射線診断科で、Medical Imaging研究をしています。

人工知能で、みんな健康かつ笑顔で暮らせる社会を実現する

AIには、人々のしたいという願望を、するという行為に変えられる力があります。同様に私たちの命を支える医療にAIを導入したMedical Imagingも、今後医療の未来を切り開いていくことでしょう。

そこで本記事ではMedical Imagingならではの意義、そして挑戦について紹介します。また、そうした諸困難を踏まえた上で私が出した解決策 (MRI/CTを使ったAI画像診断研究の成果) も述べます。

はじめに

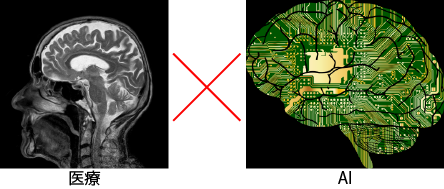

AIは医師を代替するのでは?

いいえ、あくまで普遍的解釈がなく観察者間の変動が激しい医療において、画像診断の自動化・効率化により医師の診断を助ける、自動セカンドオピニオンとして誤診を減らすのです。AIは医師とともに健康を守り人命を救うことで、全人類にとって明るい社会を実現します。

Medical Imagingとは

病気の多様性や医師の潜在的疲労による臨床意思決定の質低下を防ぐため、Computer Vision ≒ AIによって医⽤画像を解析する研究分野です。

* Computer Vision = コンピュータでデジタル画像・動画を解析する研究分野

まだ実際の導⼊事例は少ないものの、近い将来広く普及すると言われています。たとえばアメリカの一部病院ではすでに、Informed Consentのもと、AIがMCI患者のMRIから予測した、病気が進んでアルツハイマー病になってしまう確率を伝えています。

* Informed Consent = 医療行為対象者自らの意志による、医療従事者との方針の合意

タスク

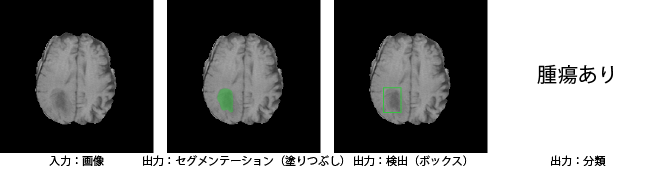

Medical Imagingの担うタスク (対象とする問題) は、AIによる病気診断が思い浮かびやすいですが、それを含め主に3つあります。

- 病気の早期検出・診断・予後予測(✕医師を代替 ○信頼できる⾃動セカンドオピニオン)

・疾患のセグメンテーション/検出/分類

・余命予測

* 専門医の見落とし防止だけでなく、非専門医の教育にも有効なはず - 医師のワークフローをイージーにする

・病気と関わる部位のみ提⽰

・⾝体部位の領域分割

・⼿術シミュレーションの提⽰/ノイズ除去 - 医師にはできない画像解析

・Radiogenomics (疾患の⾒た⽬とゲノムの関係性を紐解く)

データ

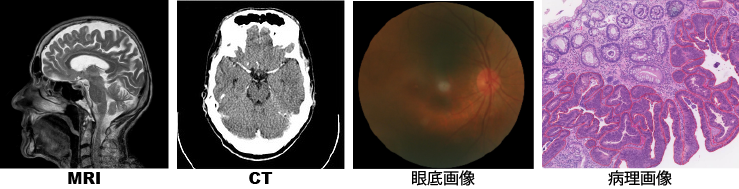

Medical Imagingの扱う主な医用画像の種類とその対象部位を紹介します。私は放射線科が専門なので、脳MRI・前立腺MRI・肺CTを扱ったことがあります。最もメジャーな医用画像は脳MRIです。対象疾患は、アルツハイマー病・ 前立腺がん ・肺結節など多岐に渡ります。

- 医用画像の種類

・放射線画像 (MRI/CT/X-ray/PET)

・内視鏡画像

・超⾳波画像

・眼底画像/OCT画像

・病理画像

・⽪膚画像 - 対象部位

・頭部 (脳/目/歯)

・胸部 (心臓/乳部/肺/胃)

・腹部 (肝臓/腸)

・脚部 (足)

・その他 (病理/皮膚)

手法

Medical Imagingの手法として、従来は確率モデリングと学習アルゴリズムがよく使われていました。ただ現在は他のComputer Visionの応用先と同じく、Deep Learningが席巻していますので、これについて述べます。

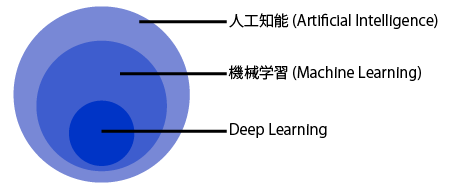

Deep Learningとは

位置づけ

- ⼈⼯知能

・⼤量の知識データに対して、⾼度な推論を的確に⾏う

・⼤量のデータの中から、価値のあるものを引っ張り出す - 機械学習

・⼈が明⽰的に挙動を指⽰せず、コンピュータに学習能⼒を与える

・⼈⼯知能の⼊⼒/処理/出⼒のうち処理のほとんどを占める

* 入出力はBig Data/Cloud Computingなど。機械学習ではなく統計学が処理を担うことも - Deep Learning

・超⼤量データがあれば⼈の介⼊なしで、 機械が⾃動的にデータから特徴を抽出できる

・ラクで正確なので、今はどの分野もこれが主流

種類

- Deep Neural Network (DNN)

・脳神経回路をモデルとするNeural Networkの中間層をDeep (多層) にしたもの

・情報伝達/処理の増加に伴い特徴量の精度や汎⽤性が上がったため、予測精度も向上した - Convolutional Neural Network (CNN)

・局所的情報を抽象化し、DNNに位置普遍性をもたせたもの

・DNNを2/3次元データに対応させたもので、動画像認識に強い

・応用例:疾患のセグメンテーション/検出/分類および余命予測 - Generative Adversarial Network (GAN)

・2つのCNNs (画像生成を担当するGenerator/生成画像が本物か偽物か判別するDiscriminator) を組み合わせたもの

・リアルな動画像生成に向いている

・応用例:画像のノイズ除去/データの水増し (MRI → CT/正常画像 → 疾患画像など)

Medical Imagingの最先端

実際にAI、特に最先端のDeep Learningは高いポテンシャルを有し、昨今では専門医と同等かそれ以上の診断精度も出しつつあります。たとえば、 下記のような大量の医用画像を用いる (主に100,000枚以上) 、印象的な研究成果が発表されています。

- 研究事例

・専門医よりも正確な、糖尿病による目の病気の識別 (2016, 関連論文1)

・専門医と同レベルの、目視での皮膚がんの識別 (2017, 関連論文2)

・専門医と同レベルの、CT画像を用いた余命の予測 (2017, 関連論文3)

・専門医よりも正確な、乳がんのリンパ節転移の識別 (2017, 関連論文4)

・364チーム参加コンペティションによる、肺炎の検出 (2018, 関連論文5)

しかし、後述の理由でこうした研究成果は限定的であり、臨床応用はなかなか進まずにいるのが現状です。

研究背景

Medical Imaging特有の難しさ

Medical Imagingには下記のような障壁があり、研究成果がデータセット依存・タスク依存になりがちです。

* データセット依存:一部病院のデータにしかAIが上手く作動しないこと

* タスク依存:いくつか (主に一つ) のタスクにしかAIが適用できないこと

- 医療の専門知識を要する (医師との協力が必要)

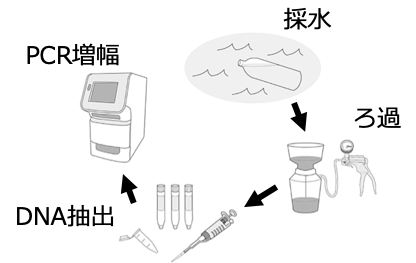

・医用画像/疾患/臨床的意義の理解や正解データ作り、妥当な結果解釈が必要なため、医師との協⼒が必要不可欠だが、医師は日常診療で忙しい - データが少ない

・特定疾患の画像取得/許可が必要なため、患者数は⼀般に10-200⼈程度にとどまる

* 国によって事情は様々で、一々許可申請が必要な日本と違って、アメリカは研究目的なら自由に利用できることが多い (そのため日本のMedical Imaging研究は圧倒的に遅れている) - データが偏っている

・疾患によって発症頻度が全然違うため、特定疾患のデータだけが多く、希少疾患だとそもそもデータが (ほぼ) ない

・患者の全体画像の中で異常の割合は、正常よりずっと少数

* 腫瘍の場合、枚数ベースで約15:85で、体積ベースで約2:98 - 医⽤画像は明瞭さに欠ける

・スマホで撮るような一般画像と比較すると、(多くの場合) 白黒/低解像度/低コントラストで、与えられた画像から得られる情報は限定的

* 特定医用画像 (例:CT/T1-weighted MRI) だけで疾患が同定できるとは限らない

* MRIの場合、単なるGaussianノイズ (正規分布における統計的ノイズ)だけでなく、渦電流によるArtifactsなど、多種多様なノイズ/バイアスが存在する - 測定装置・⽅法・個⼈・重症度による差が激しい

・病院によって測定装置/測定方法/対象患者は全然違うので、一部病院のデータから学習したAIは、他の病院のデータにはしばしば汎化失敗

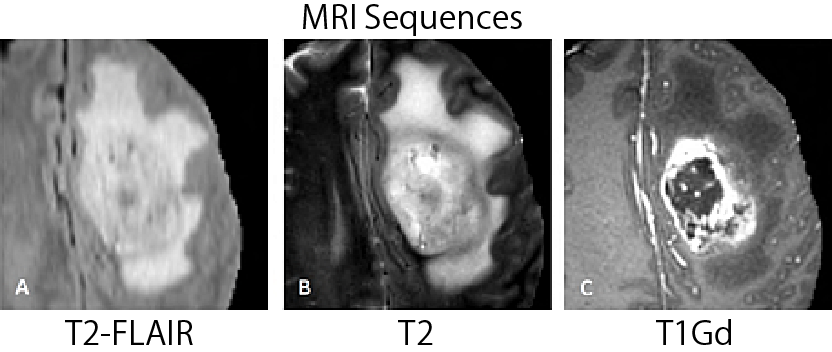

* MRIの場合、パラメータ (Sequences/磁束密度/解像度/スライス厚/スライス間隔など) によって画像の見た目は大きく変わる

* スライス厚はCTやMRIといった断層画像の厚み (例:5 mm) 、スライス間隔は前後のスライス間の距離 (例:5 mm) を指す。これらの値が大きいほど画像の連続性に欠けるため、3D画像に向かない

* MRI Sequences = パルスSequencesとパルス磁場勾配の設定。組織 (水素原子の置かれた環境) によってパルスが終わり定常状態に戻る速さが異なるので、下図のようにMRIではSequencesを使ってこの戻り方の違いを画像化できる。 戻るのにかかる縦緩和時間をT1、横緩和時間をT2と言う

* 代表的なMRI Sequencesとしては、T1-weighted MRIとT2-weighted MRIがある。前者ではT1の短い脂肪が白く、T1の長い水 (脳脊髄液など) が黒く表示される (腫瘍はやや黒) 。後者ではT2の長い水・脂肪がともに白く表示される (腫瘍はやや白)

これらを打開し、AIをより多くの病気や環境に対応させ、Medical Imagingの裾野を広げるには、これまでの知を集積する一般化が必要となります。

従来の対策

それぞれの障壁に対して、 従来はこうしたDeep Learningを使った対策がなされてきました。Medical Imagingの場合、特に前処理や問題設定、臨床的解釈が大事になってきます。

- 医療の専門知識を要する (医師との協力が必要)

・特徴マップ (AIが画像のどこを重視しているか) を可視化するなどして、Deep Learningによる意思決定や結果を医師に分かりやすく伝える

・Dropout (モデルのつながりを一部ランダムに不活性化させ、あえてモデルを弱くする) を⼊れた際に予測結果が変わるか確認することで、結果のロバスト性を医師に伝える

・臨床現場で役⽴つAIを提供するため、同じ部局にAI研究者・医師両⽅を置く

・クラウドソーシングで正解データを用意する - データが少ない

・画像全体の代わりに2D/3D画像の一部を⼊⼒にし、モデルのパラメータ数を減らす

・幾何学・強度的変換などでデータを⽔増しし、学習画像を増やす

・GANを使って、CTをもとにMRIを⽣成するなど、別Modalityからデータを引っ張ってくる

・複数タスクを少量データでMeta-training (Learning to learnとも言われる、学習アルゴリズム自体の学習) し、学習の初期化に使う

・ImageNetなど⼤量の⼀般画像を使って、 医用画像向けに転移学習 (大量の別データから学習したモデルを目的のデータに合わせて微調整) する

* ただ、中程度の規模の医⽤画像からの転移学習の⽅が良いケースもある

・MRIとCT/T1-weighted MRIとT2-weighted MRIといったふうに複数Modalities/複数Sequencesを学習の際に同時に使う

* Modalities = MRI/CTといった医用画像の種類。機械学習の文脈だとModalitiesは画像/文字/音声など、データの種類を指す - データが偏っている

・単純に正例のデータを減らし負例数に合わせる

・正例/負例の重み付けを変える

・画像を切り取って、関係の薄いところを減らす

* 頭部MRIの場合、骨や目などを除去して脳だけを残すSkull-strippingが有効 - 医⽤画像は明瞭さに欠ける

・ノイズ除去や超解像を行う

・テスト時に⼊⼒画像をランダムに壊して複数回予測し、平均値を取ることでロバスト性を上げる - 測定装置・⽅法・個⼈・重症度による差が激しい

・異なるデータセットを単純に混ぜてモデルを学習する

・GANで異なるデータセットに似た画像に変換した後、それらを混ぜてモデルを学習する

私の研究内容

私は欲張りなので、上記の5つの問題すべてをなんとかしたいと思っていますが、それは物理的に叶わないので、

- 医療の専門知識を要する (問題1)

- データが少ない (問題2)

- データが偏っている (問題3)

- 測定装置・⽅法・個⼈・重症度による差が激しい (問題5)

の4つの問題 (の一部) に取り組んでいます。この記事では、これらの解決のために行った3つのプロジェクトを紹介しましょう (その他、プロジェクト多数)。

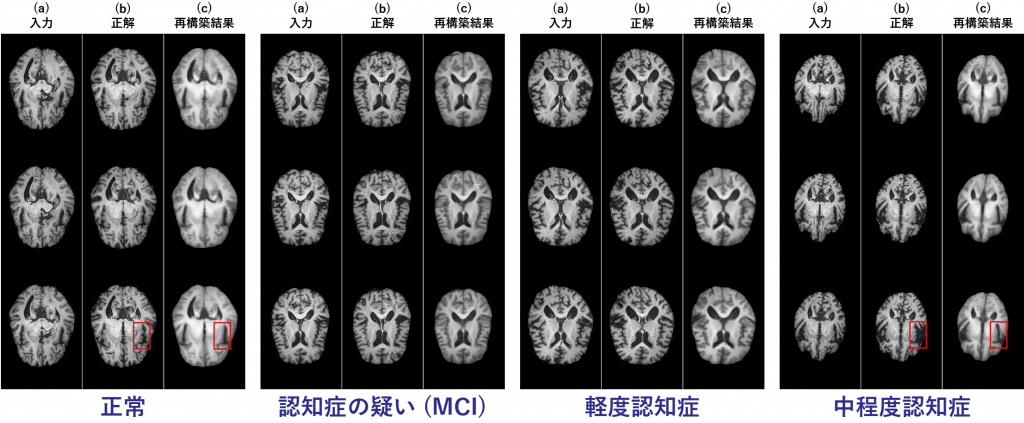

Project1 あらゆる病気を診断できる万能型画像診断

問題1. 医療の専門知識を要する (正解データ作りが必要)

問題3. データが偏っている (病気によって発症頻度が違う)

従来のAIによる画像診断は主に、特定疾患の画像で学習しその疾患だけを診断していましたが、様々な疾患の画像を大量に要すため、 (i) データセット/ 正解データ用意が困難、(ii) 画像の得難い希少疾患の診断が困難、という限界がありました。

* 希少疾患は医学的知見が少なく、精通な医師も少数なため、AIによるサポートが急務

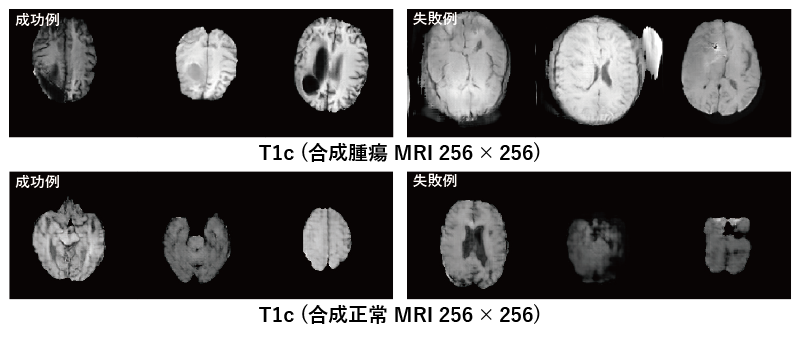

そこで逆に、超大量の正常脳MRIだけで学習したGAN (正常脳の一般化モデル) で任意 (正常/異常) の脳MRIを再構築した後、元画像と再構築画像の差分を比較することで希少疾患を含む様々な病気の診断を目指します (教師なし異常検知) 。

* 教師なし = モデルの学習に予測したいデータと同じ種類のデータ (この場合は疾患画像) を使わない

正常画像だけでモデルを学習したので、正常画像は上手く再構築できるものの、認知症が進むほど海馬・扁桃体といった脳部位が広がるため、認知症画像の再構築は失敗する。

Project2 合成医用画像を用いたデータ拡大による診断精度向上

問題2.データが少ない

従来の医用画像データ拡大 (データの水増し) は主に、元画像の幾何学的・強度的変換に頼っていましたが、これらは元画像と本質的に似た画像しか生成しないため、十分な診断精度向上は得られません。

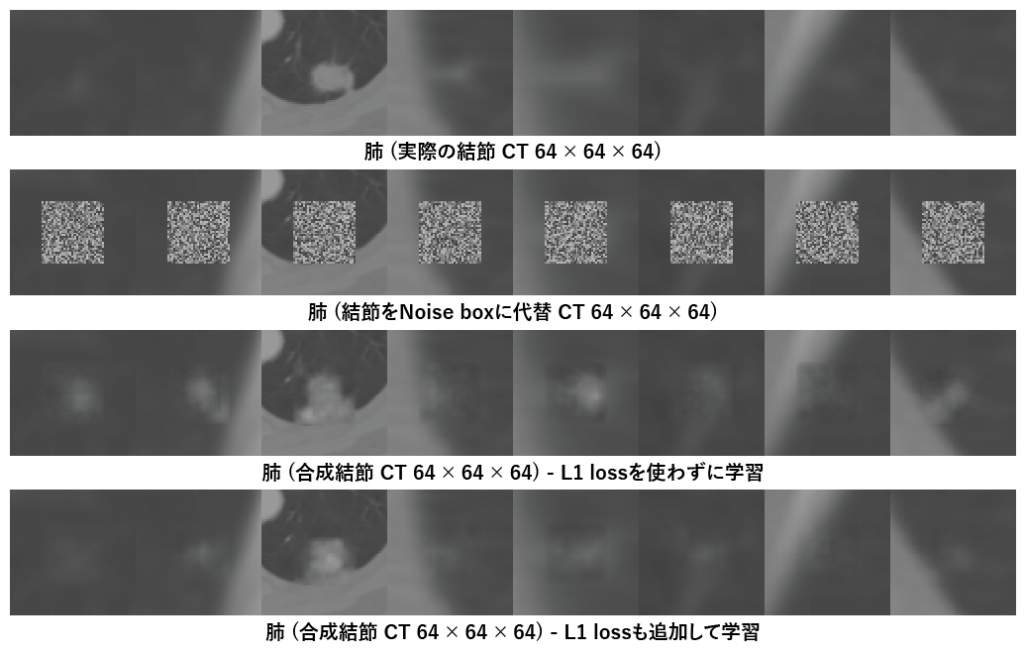

そこで、GANを脳MRI/肺CTで学習し実際の脳/肺の一般化モデルを用意することで、実画像と分布こそ似ているが個々の画像とは似ていない斬新な合成脳MRI/肺CTを生成し、診断精度向上を図ります。

直感と異なり、人間の目にはリアルでない失敗例も診断精度向上に等しく寄与する 。

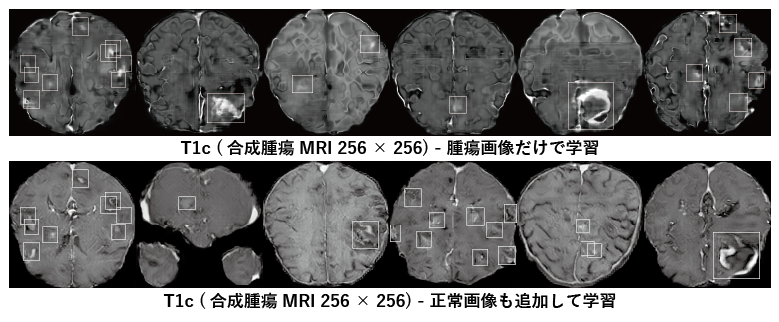

Bounding boxesの位置と大きさを指定すると、そこに腫瘍があるランダムな脳MRIを生成。直感と異なり、腫瘍画像だけで学習したリアルでない画像のほうが診断精度向上に寄与する 。

3Dだと計算量が膨大で、CT全体を生成することはできないため、合成結節だけを生成し、元の位置に貼り付ける。

Project3 複数データセットを活用した診断精度向上

問題5. 測定装置・⽅法・個⼈・重症度による差が激しい

従来のAIによる画像診断は主に、一様データからなる一つのデータセットだけで学習していましたが、医用画像は測定装置/測定方法によって解像度/コントラスト/解剖的連結などが違うため、データセット間の互換性が低くなっていました。

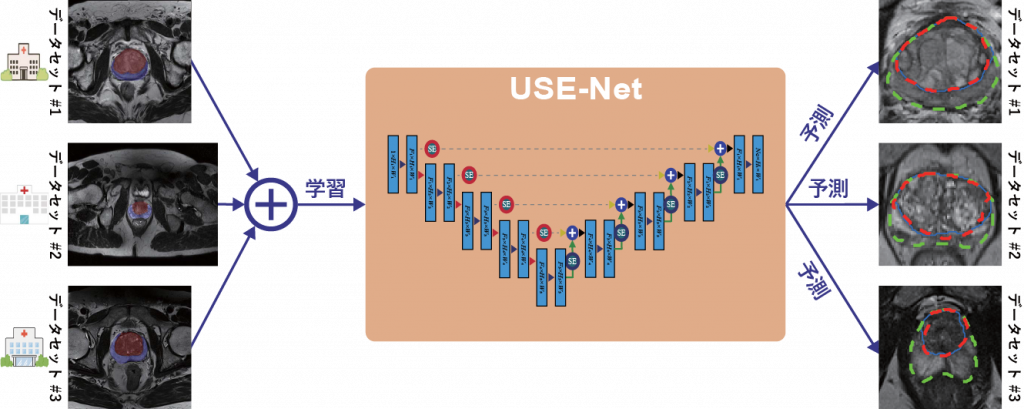

そこで、CNNで前立腺データセット間の汎化を多角的に行うことで、前立腺の区域のセグメンテーション精度向上を図ります。

予測に大きく寄与する特徴量にフォーカスするAttention機構を使って、様々なデータセット間の汎化性能をあげる。

おわりに

以上述べてきたように、Medical Imagingには臨床応用を阻む様々な技術的障壁があり、私を含む多くの研究者たちがその解決に取り組んできました。

たとえば、日本では質の高い大量の医用画像をクラウド基盤に収集し、AI画像診断を行うために、2017年11月に医療ビッグデータ研究センターが発足されました (私もその一員です)。

ここでは、データ収集/正解データ作り/個人情報保護を担当する医学系7学会と、AI画像診断を担当する6大学/研究所の情報系研究室が連携を行なっています。

* データ収集等 = 日本病理学会・日本医学放射線学会・日本消化器内視鏡学会・日本眼科学会・日本皮膚科学会・日本超音波医学会・日本医療情報学会

* AI画像診断 = 東京大学/名古屋大学/奈良先端科学技術大学院大学/九州大学/中京大学/国立情報学研究所

ただ、どれだけ技術的に優れた研究でも、それが実際に臨床応用され患者の命を救うことにつながらなければ、意味がありません。

そのため、技術のWhatだけでなく、それに関わる人間と資本も大事で、どうして使うかのWhyと、どうやってシステムを利用・普及していくかのHowもクリアする必要があります。

そこで、私は2019年3月にAI専門家 (Medical Imaging) /医師/医療・情報学にまたがるジェネラリストたちの計7人を集め、 5年後の臨床現場にフィットする医療AI創りに向けたWorkshopを東大で開催しました。

Link: https://openstudio-utokyo.com/archive/20190317-988

その成果として出た、 Why (臨床的意義や解釈) /How (データ取得) /How (収益化) / How (安全・安心) それぞれについての問題と解決策をnoteにまとめています。医療側とAI側の認識のギャップと、これらを埋めるための具体的手段が明確化できたので、ぜひご覧ください!

Link: https://note.mu/kallis/n/n7286dc4c7a01

このWorkshopの様子 (私の講義/Medical Imagingに対する期待と不安の共有/発表会/感想と有り得る応用先の共有) は、下記の私のYouTubeチャンネルに動画公開しています。

筆者紹介

私は普遍的解釈がなく、常に誤診の危険性を孕む医療を変え、みんな健康かつ笑顔で過ごせる社会を実現したいとの想いから、Deep Learningを用いたMedical Imagingの研究をしています。作家。トライリンガル (日本語・英語・韓国語)。旅人 (20カ国以上)。

研究者ページ

Link: http://changheehan.strikingly.com

私の履歴/研究内容/研究業績/研究活動を、事細かく随時更新しています。

YouTube

Link: https://t.co/2DNFdSsTC5

研究、サイエンスの本質は気づきで、我々は先人たちがやってきた圧倒的無駄を排除すべく、手間を割くための手間を割かず、「なんでできるか」「どうやればできるか」本質のバトンをつないできました。

科学はバトン、先行研究さえ繋げれば、昨日の夢は今日の希望となり、明日の現実となることを教えてくれます。かつて幼かった科学は、それを繰り返し証明してみせました。翼を持たぬ人類が今は空を飛んで、宇宙をも股にかけるようになったみたいに。

このように、価値のある気づきを共有していけば、人類だけでなく、私たち個人にも限界などはありません。安心して無知の世界ではなく、未知の世界へ飛び込めるでしょう。そこで、私のYouTubeチャンネルでは論文とは違って、 誰でも分かる形で私の気づきを発信しています。

Link: https://twitter.com/TricksterKallis

参考文献

本記事で紹介した私の論文5本を載せておきます。タイトルをクリックすると論文が見れます。

- C. Han et al., GAN-based Multiple Adjacent Brain MRI Slice Reconstruction for Unsupervised Alzheimer’s Disease Diagnosis, In Computational Intelligence methods for Bioinformatics and Biostatistics (CIBB), Bergamo, Italy, September 2019.

- C. Han et al., Combining Noise-to-Image and Image-to-Image GANs: Brain MR Image Augmentation for Tumor Detection, arXiv preprint arXiv:1905.13456, May 2019.

- C. Han, K. Murao, T. Noguchi, Y. Kawata, F. Uchiyama, L. Rundo, H. Nakayama, S. Satoh, Learning More with Less: Conditional PGGAN-based Data Augmentation for Brain Metastases Detection Using Highly-Rough Annotation on MR Images, In ACM International Conference on Information and Knowledge Management (CIKM, acceptance rate: ~19%), Beijing, China, November 2019.

- C. Han, Y. Kitamura, A. Kudo, A. Ichinose, L. Rundo, Y. Furukawa, K. Umemoto, Y. Li, H. Nakayama, Synthesizing Diverse Lung Nodules Wherever Massively: 3D Multi-Conditional GAN-based CT Image Augmentation for Object Detection, In International Conference on 3D Vision (3DV, acceptance rate: ~30%), Québec City, Canada, September 2019. Student Travel Grant

- C. Han*, L. Rundo*, et al., USE-Net: incorporating Squeeze-and-Excitation blocks into U-Net for prostate zonal segmentation of multi-institutional MRI datasets, Neurocomputing (impact factor: 4.072), July 2019.

* denotes Co-first Authors

本記事で紹介した最先端研究事例の元論文5本も合わせて載せます。

- V. Gulshan et al., Development and Validation of a Deep Learning Algorithm for Detection of Diabetic Retinopathy in Retinal Fundus Photographs, JAMA, 316 (22), 2402-2410, December 2016.

- A. Esteva et al., Dermatologist-level classification of skin cancer with deep neural networks, Nature, 542 (7639), 115, February 2017.

- L. Oakden-Rayner et al., Precision radiology: predicting longevity using feature engineering and deep learning methods in a radiomics framework, Sci. Rep., 7 (1), 1648, May 2017.

- B. E. Bejnordi et al., Diagnostic assessment of deep learning algorithms for detection of lymph node metastases in women with breast cancer, JAMA, 318 (22), 2199-2210, December 2017.

- I. Pan et al., Tackling the Radiological Society of North America Pneumonia Detection Challenge, AM J. Roentgenol., 1-7, May 2019.

この分野の仕組みやトレンドついてより詳しく知りたい人のために、Medical Imagingのレビュー論文2本も紹介しておきます。

- D. Shen et al., Deep learning in medical image analysis, Annu. Rev. Biomed., 19, 221-248, June 2017.

- B. Sahiner et al., Deep learning in medical imaging and radiation therapy, Med. Phys., 46 (1), e1-e36, November 2018.